Um grupo de pesquisadores da Universidade de Chicago está desenvolvendo uma ferramenta para “envenenar” plataformas de inteligência artificial (IA). A ideia é modificar imagens para que elas, caso sejam usadas em modelos de linguagem, prejudiquem o treinamento de uma IA.

A ferramenta se chama Nightshade e foi desenvolvida para “quebrar” IAs generativas alimentadas por imagens que deveriam ser protegidas por direitos autorais. Em vários casos, ilustrações foram incluídas no treinamento de uma plataforma sem autorização.

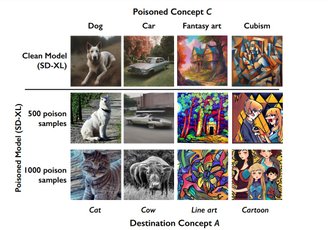

Como resultado, plataformas afetadas podem não ser mais capazes de gerar objetos, animais ou certos estilos artísticos com realismo. No pior dos casos, ela pode até mesmo perder a capacidade de reconhecimento de elementos e não saber mais o que é um cachorro ou uma cadeira, por exemplo.

Imagens “envenenadas” pioram o desempenho de uma IA.Fonte: Arxiv.org

Companhias como Meta, OpenAI (dona do DALL-E) e Stable Diffusion são os principais alvos dessa criação.

Plataformas geradoras de imagens por IA dessas companhias são capazes de “replicar” elementos gráficos e identidades visuais de artistas que nunca concordaram em ter seus trabalhos usados nesses serviços.

Como funciona o “envenenamento” de IAs de imagem

A Nightshade é uma modificação da imagem ao nível de pixel, que não alterar a aparência final do arquivo. Ela é implementada quando alguém publica o trabalho online em uma página da internet sem autorizar o seu uso em IAs generativas.

Quando um modelo de linguagem usa o trabalho sem autorização para treinamento, os dados modificados “envenenam” o modelo de linguagem, confundem o sistema e passam a prejudicar todo o processo de aprendizado da IA.

IAs confusas pela modificação dos dados perdem a capacidade de replicar estilos.Fonte: Arxiv.org

IAs confusas pela modificação dos dados perdem a capacidade de replicar estilos.Fonte: Arxiv.org

Os responsáveis precisam encontrar os arquivos danificados manualmente e removê-los para não contaminar todo o sistema.

Nos testes realizados, 50 imagens “envenenadas” de cachorros foram o suficiente para uma versão controlada da Stable Difussion já perder a capacidade de recriar o animal com fidelidade. Ao usar 300 ilustrações, a IA começa até a confundir animais e começar a gerar gatos no lugar.

Lançamento ainda indefinido

A Nightshade está em fase de desenvolvimento. Um artigo científico com os resultados prévios do projeto foi submetido no repositório do arXiv, mas ainda não passou por uma revisão por pares.

Além disso, o trabalho levanta algumas questões. Esse mesmo processo pode ser usado para fins criminosos ou até de brincadeira para piorar IAs legalizadas, por exemplo. Outro ponto discutido é que a vulnerabilidade que “confunde” o aprendizado pode ser sanada eventualmente pelas desenvolvedoras.

O objetivo da equipe de cientistas, liderada pelo professor Ben Zhao, é implementar a ferramenta em outro trabalho do grupo, o Glaze. Assim como outras ferramentas parecidas, ele “esconde” estilos artísticos de imagens para que IAs não consigam copiá-los.